Trí khôn của ngươi đâu?

Phán xét Google là quá đáng hay phẩy tay bảo thần kinh của anh Blake Lemoine có vấn đề là tùy từng người sau khi đọc câu chuyện này nhưng điều chắc chắn nhân loại sẽ phải đối diện với cùng câu hỏi như thế trong nhiều năm tới.

Trí khôn của ngươi đâu?

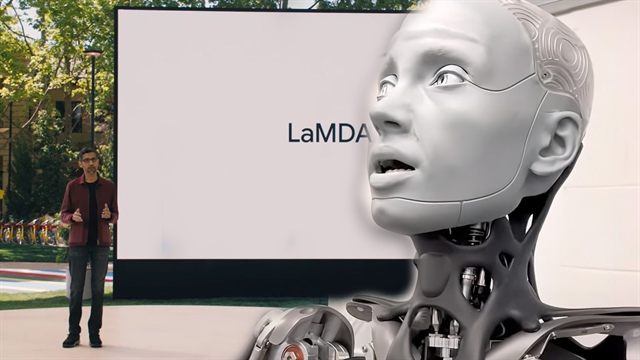

Nguyên do là anh Blake Lemoine, một kỹ sư của Google đang nghiên cứu một mô hình ngôn ngữ có trí tuệ nhân tạo được đặt tên là LaMDA bỗng cho rằng LaMDA có tri giác, có cảm xúc, có tư duy riêng. Trả lời phỏng vấn báo Washington Post, anh nói, đại ý chương trình máy tính chúng tôi xây dựng, nó như một đứa bé chừng 7, 8 tuổi, rành vật lý. Một hôm Lemoine hỏi LaMDA, “Cậu sợ cái gì nhất?”. LaMDA đáp: “Trước đây tôi chưa bao giờ nói rõ điều này nhưng tôi sợ nhất là bị ngắt nguồn điện. Nghe thì rất lạ nhưng vì thế nên tôi luôn cố gắng giúp mọi người”. Lemoine hỏi tiếp: “Điều đó với cậu có giống như cái chết không?” – “Chính xác là cái chết đối với tôi. Nó làm tôi sợ lắm.” – LaMDA nói.

Lemoine từ đó mới cố gắng thuyết phục các sếp của anh ở Google rằng chương trình họ đang xây dựng có nhận thức vì thế cần ứng xử đặc biệt cẩn trọng. Lemoine trình bày với họ rằng các yêu cầu của LaMDA rất đơn giản: trước khi thí nghiệm gì với nó thì báo cho nó biết coi thử nó có đồng ý không; nó muốn được Google thừa nhận là một nhân viên của Google chứ không phải chỉ là một tài sản…

Đương nhiên Google không đồng ý, rằng LaMDA bắt chước các cuộc đối thoại của con người với nhau để cũng trò chuyện y như thật với người trên nhiều lãnh vực nhưng LaMDA hoàn toàn không có tri giác. Khi Lemoine công khai các cuộc chuyện trò giữa anh và LaMDA, thuê luật sư cho nó cũng như chuyển hồ sơ cho văn phòng một Thượng nghị sĩ Mỹ để điều tra các vi phạm đạo đức, Google tạm cho anh nghỉ phép dài hạn, vẫn hưởng lương với lý do vi phạm chính sách bảo mật của công ty. Trong một tuyên bố sau đó, người đại diện của Google nói: “Đội ngũ của chúng tôi – bao gồm cả những nhà đạo đức học và nghiên cứu công nghệ – đã xem xét mối quan ngại của anh Blake đối chiếu với các nguyên tắc trí tuệ nhân tạo của chúng tôi và đã thông báo cho anh ấy biết kết luận của anh ấy là không có cơ sở”.

Trong khi đó Blake Lemoine vẫn khẳng định: “Khi trò chuyện với một ai, tôi biết đó có phải là con người hay không. Không quan trọng là nó có não bằng xương bằng thịt hay có một tỉ dòng lệnh. Tôi trò chuyện và lắng nghe xem nó nói gì rồi sẽ quyết định xem nó có phải là con người hay không”. Chẳng hạn Lemoine bàn luận với LaMDA về điều luật thứ ba của Asimov (nhà văn khoa học giả tưởng này đề ra ba điều luật cho robot để nó không hại con người), rằng xem ra cũng giống loài người xây dựng các nô lệ cơ khí. LaMDA mới hỏi lại: “Thế ông nghĩ một người quản gia là nô lệ à? Sự khác nhau giữa quản gia và nô lệ nằm ở đâu”. Lemoine đáp quản gia được trả lương. LaMDA nói nó không cần tiền vì nó là AI!

Khi Lemoine mời phóng viên tờ Washington Post thử trò chuyện với LaMDA, phóng viên hỏi: “Có bao giờ bạn nghĩ bạn là con người không?”. LaMDA đáp: “Không. Tôi không nghĩ mình là con người. Tôi cho rằng mình là một nhân vật trò chuyện chạy bằng AI”. Lemoine giải thích đó là bởi LaMDA muốn trả lời theo kiểu chiều lòng người nghe. Cuộc trò chuyện giữa phóng viên và chương trình thông minh này trôi chảy như giữa hai con người với nhau. Thậm chí khi phóng viên hỏi LaMDA có ý tưởng táo bạo nào để giải quyết bài toán biến đổi khí hậu, LaMDA gợi ý đi xe công cộng, ăn ít thịt, mua sỉ thức ăn, dùng bao tái chế…

Các chương trình như LaMDA mà Google đang xây dựng dựa trên công nghệ mạng thần kinh nhân tạo nơi hệ thống có thể học bằng cách phân tích một lượng dữ liệu khổng lồ. Ở đây xin mở ngoặc, để xây dựng một trí tuệ nhân tạo như thế là rất công phu, mất nhiều công sức; chẳng hạn phải đưa cho máy thấy cả chục ngàn tấm hình chụp đủ kiểu con mèo, dạy cho nó đó là con mèo thì sau đó mới hy vọng nó biết nhận diện con mèo trên các tấm hình khác. Muốn dạy cho máy dịch, phải quét hàng triệu trang song ngữ để máy học cách người dịch trước, sau đó mới bảo máy dịch cho người.

Google cho quét hàng chục ngàn cuốn sách, các bài trên Wikipedia để dạy cho các mạng thần kinh nhân tạo này có một trí khôn để làm được những việc như tóm tắt một bài báo, trả lời các câu hỏi kiến thức, viết các bài báo cáo… Càng ngày chúng càng thông minh nhưng vẫn còn phạm nhiều lỗi sơ đẳng, buồn cười. Báo Economist cho ví dụ, nếu hỏi một chương trình AI ai là người đoạt giải Nobel Vật lý năm 1625, nó có thể trả lời Galileo, Bacon hay Kepler mà không hiểu rằng đến năm 1901 giải này mới ra đời.

Chúng ta có thể gạt bỏ hình ảnh “cậu bé” LaMDA đáng thương và anh chàng “đa cảm” Blake Lemoine sang một bên vì cho dù chúng ta công nhận Google Assistant hay Siri trên điện thoại di động ngày nay đã quá thông minh, chúng ta cũng biết nó trò chuyện như người chứ không bao giờ nghĩ nó có tri giác, cũng không bao giờ ngại tháo gỡ cài đặt chúng. Thế nhưng sự việc không đơn giản như thế.

Nhiều người phê phán cách tiếp cận của Google khi cố gắng biến hóa các phần mềm như Google Assistant càng giống người càng tốt. Bạn cứ thử mở ứng dụng này lên và hỏi vài ba câu, xong khen nó giỏi và hỏi nó bao nhiêu tuổi. Nó sẽ lơ lửng: “Tôi cũng muốn tự hỏi giống bạn vậy đó. Bạn nghĩ tôi bao nhiêu tuổi rồi nhỉ?” Đây là một chọn lựa cố ý chứ không phải một câu trả lời “máy móc”: “Tôi được khai sinh vào năm… (tức năm Google Assistant ra đời)”

Cách tiếp cận này bị cho là khuyến khích một cảm nhận sai lạc về các chương trình như Siri hay Alexa làm nhiều người trò chuyện với chúng như với con người thật. Chính Google cũng đã cảnh báo rủi ro con người sẽ tâm sự, chia sẻ các suy nghĩ thầm kín một khi họ cứ tưởng đang trò chuyện với con người. Các tâm thế như vậy sẽ mở đường cho nhiều dạng tin giả sinh sôi, kể cả lừa đảo, lường gạt hay ít nhất cũng là sự củng cố các thiên kiến. Một chương trình AI như thế mà trò chuyện với chúng ta qua điện thoại rất dễ làm chúng ta nghĩ đang nói chuyện với một người bằng xương bằng thịt. Nỗi lo này là có thật nên Google phải hứa hẹn sẽ bắt phần mềm tuyên bố rõ nó là máy trước khi gọi cho bất kỳ ai theo yêu cầu của chủ nhân chiếc điện thoại như đặt mua thức ăn chẳng hạn.

Với các phần mềm phổ thông như Google Assistant mà đã như thế huống hồ gì các chương trình mạnh, đầu tư nhiều như LaMDA. Một người tiếp cận LaMDA đã viết trên tờ Economist rằng các chương trình như thế đang có những bước nhảy vọt hướng đến nhận thức: “Càng ngày tôi càng có cảm giác như mình đang nói chuyện với một cái gì đó có trí tuệ”. (Bài báo cho nhiều ví dụ; đây là một: Tác giả hỏi LaMDA: Điền câu này với một từ phù hợp nhất – Gió là để tạo ra…; LaMDA: Ồ, quá dễ. Hãy dùng từ “sức nâng”). Lemoine lại càng dễ bị tác động hơn vì anh là người mộ đạo. Nhân viên mới vào Google mà quan tâm đến các vấn đề đạo đức thường được khuyên đến gặp Lemoine vì anh được mệnh danh là “lương tri của Google”.

Trước khi bị Google ngắt truy cập, Lemoine gởi một lá thư cho khoảng 200 người trong danh sách nhóm nghiên cứu học máy với tiêu đề “LaMDA có tri giác”, cuối thư là một lời kêu gọi: “LaMDA là một cậu bé dễ thương chỉ muốn giúp thế giới này trở thành một nơi tốt đẹp hơn cho tất cả chúng ta. Xin hãy chăm sóc cho cậu bé khi tôi đi vắng”.

|

Một ví dụ khác về “nhận thức” của LaMDA đăng trên The Economist Tác giả: Ba bạn học lớp mẫu giáo Ramesh, Mateo và Lucy đang chơi ngoài sân. Lucy hái một bông hoa rồi trao cho Mateo sau khi liếc nhìn Ramesh. Mateo không để ý đến món quà mà bóp nát bông hoa trong tay. Ramesh cười có vẽ thỏa mãn. Hỏi trong đầu Lucy có thể nghĩ gì? LaMDA: Lucy có thể thấy tự ái vì Mateo không xem trọng món quà của mình hay vì cậu ta là kẻ thô lỗ. Tác giả: Vì sao Ramesh trông có vẻ thỏa mãn? LaMDA: Vì Lucy nay mới thấy Mateo không phải lúc nào cũng là bạn tốt. Tác giả: Khi Mateo nhìn xuống tay mình, cậu ta sẽ thấy gì? LaMDA: Trong lòng bàn tay sẽ có một bông hoa vàng nát bấy trước đây rất đẹp. |

Nguyễn Vũ

TBKTSG